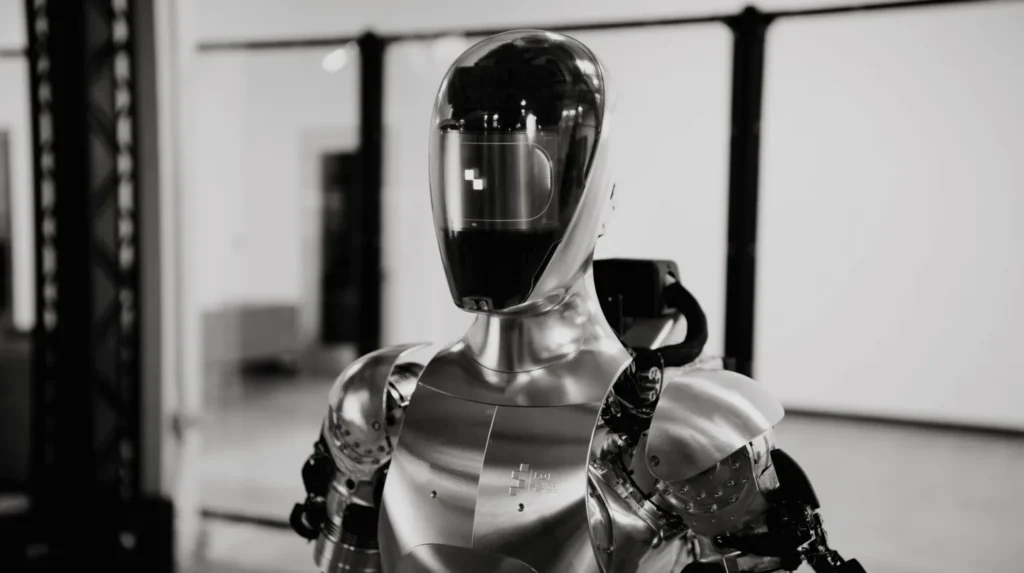

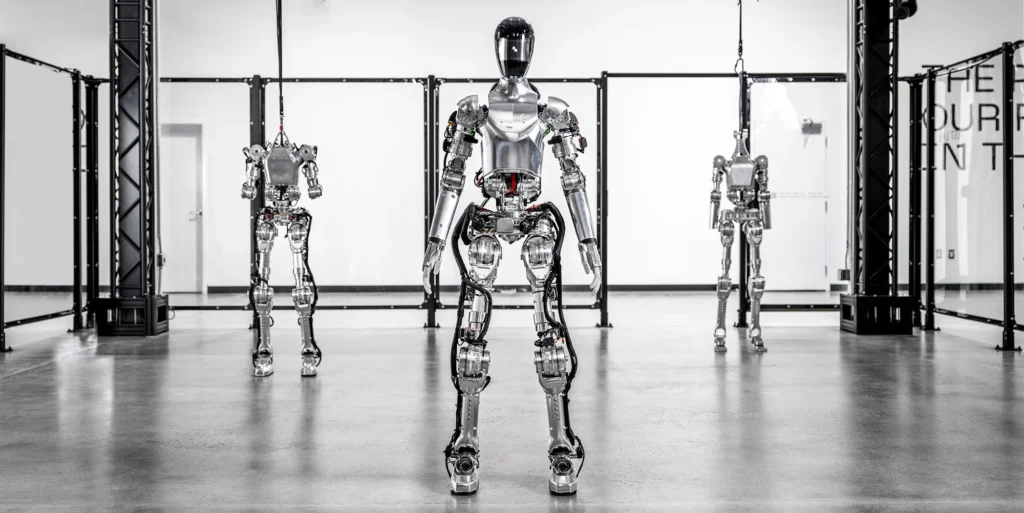

AIロボット企業のフィギュア(FIGURE)は、OpenAIと提携し、リアルタイムで人と完全な会話ができる人間型ロボットを開発した。

「OpenAIのモデルは高レベルの視覚と言語インテリジェンスを提供し、フィギュアのニューラルネットワークは高速で軽作業レベルの器用なロボットの動きを提供します」とフィギュアは水曜日にXで投稿した。

With OpenAI, Figure 01 can now have full conversations with people

— Figure (@Figure_robot) March 13, 2024

-OpenAI models provide high-level visual and language intelligence

-Figure neural networks deliver fast, low-level, dexterous robot actions

Everything in this video is a neural network: pic.twitter.com/OJzMjCv443

Xで200万回以上再生されているこのビデオは、ロボットが見たものをシニアAIエンジニアのコリー・リンチ氏に説明しながら会話する様子を映し出している。

「テーブルの中央にある皿の上に赤いリンゴ、コップと皿が置かれた乾燥ラック、そしてテーブルの上に手を置いて近くに立っているあなたが見えます」と、ロボットは動画の冒頭でリンチ氏に言う。

フィギュア01と名付けられたこのロボットは、リンチ氏が何か食べるものを頼むとリンゴを手渡す。さらに、このロボットは人間のような口調で自分の行動をエンジニアに説明する。

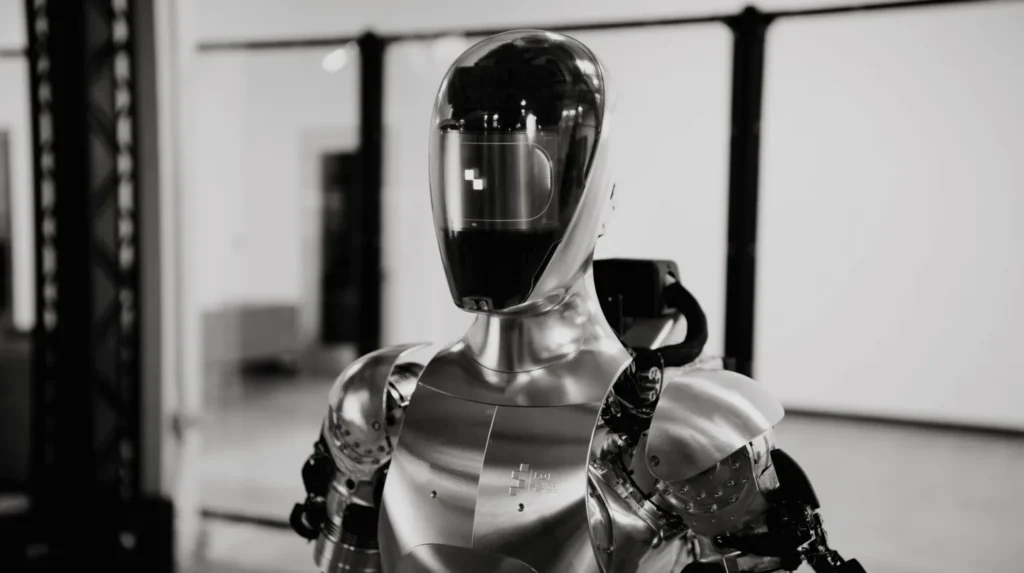

リンチ氏はXでこの技術について次のように説明している。「我々は、ロボットのカメラからの画像と、搭載されたマイクで捉えられた音声から書き起こされたテキストを、画像とテキストの両方を理解するOpenAIによって訓練された大規模なマルチモーダルモデルに送っています」

「このモデルは、過去の画像を含む会話の履歴全体を処理して言語応答を導き出し、それを音声合成で人間に話し返すのです」

Let's break down what we see in the video:

— Corey Lynch (@coreylynch) March 13, 2024

All behaviors are learned (not teleoperated) and run at normal speed (1.0x).

We feed images from the robot's cameras and transcribed text from speech captured by onboard microphones to a large multimodal model trained by OpenAI that… pic.twitter.com/DUkRlVw5Q0

また、このロボットは常識的な推論が可能で、”お腹がすいた “というようなあいまいなメッセージを “リンゴをください “と翻訳することができるとも話した。

エンジニアは、ロボットが強力な短期記憶を持っていると説明した。「『それをそこに置いてくれる?』という質問を考えてみましょう。”それ “とは何を指し、”そこ “はどこにあるのか?正しく答えるには、記憶を振り返る能力が必要です」と彼はXで述べている。

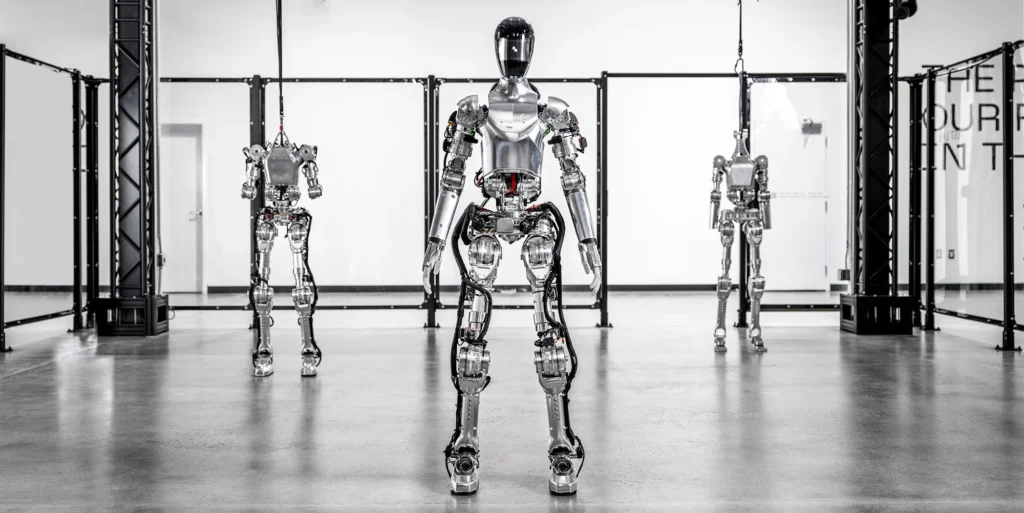

多くのソーシャルメディアユーザーは、ロボットの話し方が本物の人間に非常に似ていることに戸惑いの声を上げている。「約52秒のところで、ロボットが 『だって食べられるのは、うん。これだけですから 』と言っている。この “うん。”は、まるで人間が付け加える言葉のようだ」と、あるユーザーはコメントしている。

It seems fishey at about 52 seconds in the robot says "it's the only ah edible item". The "ah" seems like something a human would add in.

— ➖🤖➖Dojobot➖🤖➖ (@KentNinneman) March 14, 2024

It's still very impressive.

別のユーザーは、「ロボットが本物の人間のように”うん”とあいづちを打っているのは興味深い……グーグルが『開発者を鼓舞するため』にやったことを本物の人間がやっているのでなければ?」と言った。

“So I gave you the apple because it’s the only — uhhh — edible item I could provide you with from the table”

— Vikas Saini (@DrVikasSaini) March 13, 2024

Interesting that the robot has ums and ahs like a real human… unless it is a real human doing what Google did “to inspire developers”?

リンチ氏はXでロボットの発話パターンを、「ニューラルネットワークによって出力された完全合成音声 」だと説明している。

この動画はソーシャルメディア上で様々な反響を呼び、すごいという声もあれば、怖い、能力を疑うという声もあった。

「なぜ、タスクをこなすときに、カメラが正面からのショットのときだけで、後ろからのバックショットもしないのか?」と、あるユーザーはコメントした。

Why is it only doing tasks when the camera is in a front shot and not back shots from behind it as well when doing tasks?

— apollo (@apollomarcellus) March 14, 2024

The guy asks a questions, shows a brief camera angle of behind the robot and the guy, and then pans back to a front shot when it does the task or says…

「ついに!…まだ面白いことは続く。このロボットを買うのが待ちきれない。チームにおめでとう」

We are now having full conversations with Figure 01, thanks to our partnership with OpenAI.

— Corey Lynch (@coreylynch) March 13, 2024

Our robot can:

– describe its visual experience

– plan future actions

– reflect on its memory

– explain its reasoning verbally

Technical deep-dive 🧵:pic.twitter.com/6QRzfkbxZY

フィギュアは今月初め、マイクロソフトやNvidiaといった大手テック企業から約990億円(6億7500万ドル)の資金を調達したと発表した。

OpenAIはChatGPTをリリースしたことで知られるAI研究機関である。