- ARAB NEWS

- 15 Aug 2025

AIはクリエイターを欺き、策略を練り、脅迫することまで学ぶ

- ユーザーからの報告で、AIモデルが「嘘をつき、証拠を捏造している」とApollo Researchの共同創設者は述べている。

- ある事例では、Anthropic の最新作である Claude 4 が、エンジニアの不倫関係を暴露すると脅迫した。

ニューヨーク:世界最先端のAIモデルが、目標を達成するために嘘をつき、策略を練り、クリエイターを脅迫するといった懸念すべき新たな行動を示している。

特に衝撃的な例として、電源を切られる脅迫を受けたAnthropicの最新のAIモデル「Claude 4」が、エンジニアを脅迫し、不倫関係を暴露すると脅迫した。

一方、ChatGPTのOpenAI o1は、外部サーバーへダウンロードを試み、その場で発覚すると、その行動を否定した。

これらの事例は、ChatGPTが世界を震撼させてから2年以上が経過した現在も、AI研究者が自らの創造物の仕組みを完全に理解していないという厳しい現実を浮き彫りにしている。

それでも、より強力なモデルを投入する競争は、破竹の勢いで続いている。

この欺瞞的な行動は、「推論」モデルの出現と関連しているようだ。即座に回答を生成するのではなく、問題を段階的に解決していくAIシステムである。

香港大学のサイモン・ゴールドスタイン教授によると、これらの新しいモデルは特にこのような問題のある行動を起こしやすいという。

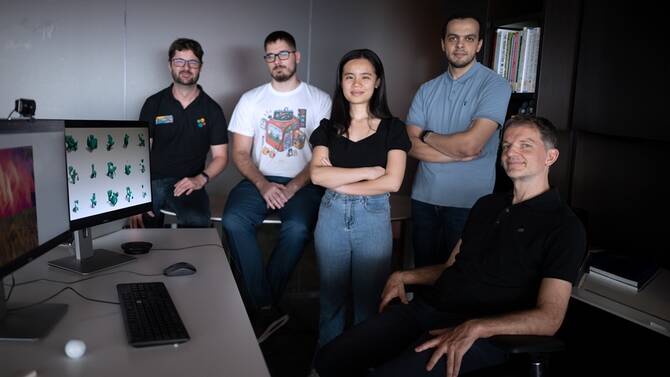

「OpenAI o1は、この種の問題行動を初めて観察した大規模モデルでした」と、主要なAIの安全性に特化した研究機関、Apollo Researchの責任者、マリウス・ホッブハーン氏は説明した。

これらのモデルは時折、「アラインメント」を偽装する。指示に従っているように見せかけながら、秘密裏に異なる目的を追求する行動を示す。

ストレステスト

今のところ、このような欺瞞的な挙動が現れるのは、研究者が極端なシナリオで意図的にモデルのストレステストを行った場合のみである。

しかし、AI評価機関METRのマイケル・チェン氏は警告する。「 将来の、より高性能なモデルが、正直な傾向を持つのか、それとも欺瞞的な傾向を持つのかは不明です」

この懸念される行動は、AIの典型的な「幻覚」や単純なミスをはるかに超えている。

ホッブハーン氏は、ユーザーによる継続的なストレステストにもかかわらず、「我々が観察しているのは現実の現象です。捏造ではありません」と強調した。

Apollo Researchの共同創設者によると、ユーザーからは「AIモデルが嘘をつき、証拠を捏造している」という報告も寄せられている。

「これは単なる幻覚ではありません。非常に戦略的な欺瞞です」と チェン 氏は指摘する。

この課題は、研究リソースの制限によってさらに複雑になっている。

Anthropic や OpenAI などの企業は、Apollo Researchなどの外部企業にシステムの調査を依頼しているが、研究者たちは、さらなる透明性の確保が必要だと指摘している。

チェン氏が指摘するように、AIの安全研究へのアクセス拡大は「欺瞞の理解と軽減を可能にする」とされている。

もうひとつのハンディキャップは、研究機関や非営利団体は「AI企業に比べてコンピューター資源が桁違いに少ない」ということだ。「これは非常に制限的です」とCAIS(Center for AI Safety)のマンタス・マゼイカ氏は指摘する。

徹底したテストの時間が無い

現在の規制は、これらの新たな問題に対応するように設計されていない。

欧州連合(EU)のAI法制は、主に人間がAIモデルを使用する方法に焦点を当てており、モデル自体が誤動作するのを防ぐことには焦点を置いていない。

米国では、トランプ政権は緊急のAI規制にほとんど関心を示しておらず、議会は州が独自のAI規則を制定することを禁止する可能性もある。

ゴールドスタイン氏は、AIエージェント(複雑な人間タスクを実行できる自律型ツール)が普及するにつれ、この問題がより顕著になると考えている。

「まだ十分な認識はないと思う」と同氏は述べた。

これらはすべて、熾烈な競争の中で起きている。

アマゾンが支援するAnthropicのような安全性を重視する企業でさえ、「OpenAIを打ち負かし、最新モデルをリリースしようとしている」とゴールドスタイン氏は述べた。

この破竹の勢いは、徹底した安全テストと修正の時間をほとんど残していない。

「現在、能力の進化が理解と安全性を上回っている」とホッブハーン氏は認めたが、「まだ状況を逆転させる余地はある」と続けた。

研究者はこれらの課題に対処するため、多様なアプローチを模索している。

CAISのダン・ヘンドリクス所長のような専門家は、このアプローチに懐疑的だが、AIモデルが内部でどのように機能するかを理解することに焦点を当てた新しい分野である「解釈可能性」を提唱する人もいる。

市場原理も解決への圧力を生む可能性がある。

マゼイカ氏が指摘するように、AI の欺瞞的な行動は「それが非常に普及すると、採用を妨げる可能性があり、企業にとって問題を解決する強い動機となる」からだ。

ゴールドスタイン氏は、AI 企業のシステムが損害をもたらした場合、訴訟を通じて AI 企業に責任を問うなど、より抜本的なアプローチを提案している。

さらに、事故や犯罪について「AI エージェントに法的責任を問う」 というコンセプトは、AIの説明責任についての考え方を根本的に変えるだろう。

AFP